2021-01-25

Google Analytics est mort, vive Google Analytics 4 !

près 8 ans passés sur le front de la collecte et de l’analyse data, Google Analytics Universal a cédé sa position d’outil de référence à son successeur : Google Analytics 4. L’arrivée de GA 4 – initialement App + Web – marque donc un tournant majeur et nécessaire dans la collecte et l’activation data.

Nécessaire, car il répond à de profonds changements de comportement des utilisateurs, de politique des acteurs du marché, ou encore de cadre législatif ; majeur, car il modifie radicalement le traitement de la donnée, depuis sa collecte jusqu’à son activation

Et bien sûr, ce tournant prend tout son sens au regard de la transformation digitale des marques vers des structures, des prises de décision et des actions guidées par la donnée et son relatif pragmatisme (le fameux pilotage data driven).

Alors intéressons-nous à GA 4 sous cet angle. Car si l’annonce de son déploiement est encore toute récente, cela fait plus d’un an que Jellyfish s’y prépare.

Google Analytics Universal, la fin d’une ère…

Si l’on regarde le présent, la disparition de Google Analytics Universal prend sa source dans une double évolution : sociale et technologique. En effet, les utilisateurs attendent aujourd’hui une expérience homogène et des interactions pertinentes avec les marques, et ce dans un contexte de sur-sollicitation. Et s’ils consomment davantage de digital, ces mêmes utilisateurs exigent logiquement de voir leur vie privée en ligne mieux respectée !

La collecte de données, dépendant du recueil du consentement et des limitations technologiques, devient donc moins exhaustive, et la donnée 3rd party perd en qualité là où elle aurait pu construire une ébauche de réponse aux besoins d’homogénéité.

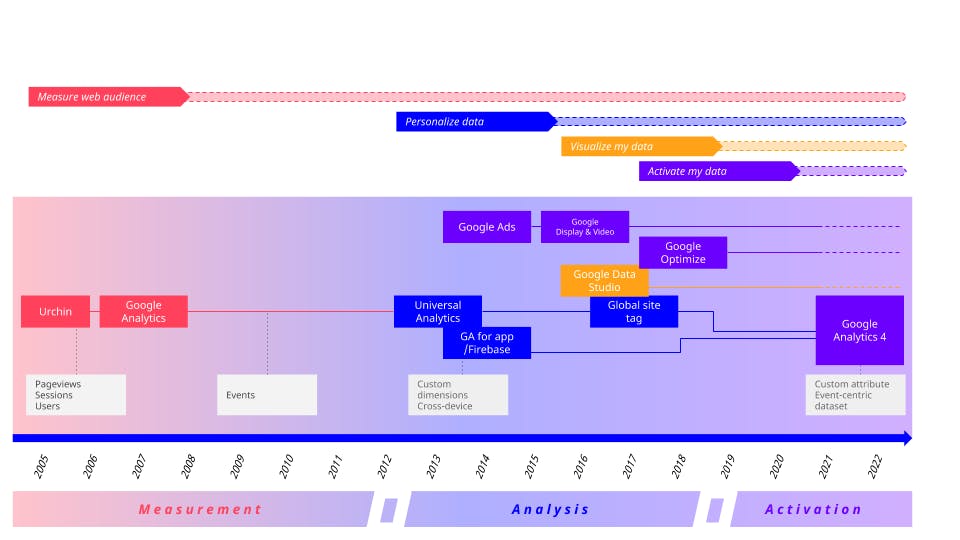

En second lieu, d’un point de vue outil, l’arrivée de GA 4 s’inscrit dans une logique d’évolution des usages en webanalyse et en prenant du recul, on peut distinguer 3 ères successives dans l’approche de Google :

1. L’ère de la mesure : basique et pragmatique (“je veux mesurer mon audience”).

2. L’ère de l’analyse : personnalisation de la collecte, création de reportings statiques et dynamiques, et avènement de Firebase (“je veux estimer la performance”)

3. L’ère de l’activation : interconnection des outils, tels que Google Ads, Optimize, Firebase AB (“je veux faire de ces données un levier de ROI”).

L’apparition de GA 4 s’inscrit dans cette troisième ère où les conditions et les priorités respectives de la collecte, l’analyse et l’activation changent pour mieux répondre aux besoins et aux fameux défis évoqués en amont.

En quelques mots, cette nouvelle ère s’appuie via la collecte sur une interconnexion renforcée de tous les outils du stack Google, permettant le machine learning, la vision people based et une activation plus directe de la donnée.

Car en effet, la collecte (ici la donnée first party) ne peut créer de valeur pour la marque que si elle est collectée et structurée dans l’objectif de construire un axe unique (et court) reliant média, navigation onsite et offsite – #interconnexion donc.

La collecte ne peut créer de la valeur que si elle peut être transformée et sublimée pour pallier la perte d’information causée par la privacy – #MachineLearning. Et enfin la collecte ne peut créer de la valeur que si elle vient construire une vision people-based dans un monde bientôt cookieless.

Lier marketing et technologie est ainsi un levier essentiel de maturité, permettant de donner une valeur croissante à l’actif data dans un écosystème où les enjeux de privacy et data quality sont centraux.

Et c’est pour suivre ces logiques que la data collectée se doit absolument d’être flexible, désilotée et actionnable en temps réel. Lier marketing et technologie est ainsi un levier essentiel de maturité, permettant de donner une valeur croissante à l’actif data dans un écosystème où les enjeux de privacy et data quality sont centraux. GA 4 donne ainsi accès à une donnée toujours plus hybride.

… Et une révolution stratégique

La collecte de données sert un scope plus large d’intérêts

Là où la collecte se suffisait à elle-même avec GA Universal, avec GA 4 elle est pensée pour servir un scope large et varié d’intérêts. Ainsi, stockage, analyse et activation sont au service de cas d’usage cross-platform et média, onsite et offsite.

Pour preuve, GA 4 donne une vision unifiée de la collecte et de la performance en intégrant nativement des métriques multi-platform. Par ailleurs la normalisation des conventions de nommage (enfin !) permet d’intégrer des rapports pré-construits basés sur le machine learning – tels que la probabilité de churn, et il faudra aussi compter sur l’avènement futur de rapports par verticale qui permettent d’aller encore plus loin dans la compréhension de la data.

Pour finir, afin de répondre aux enjeux de respect de la vie privée des utilisateurs, la collecte de GA 4 est construite pour être privacy-by-design en se basant sur des règles de consentement et l’extrapolation au sein de rapports pré-construits !

Une exploration de la donnée plus agile

Mais si GA 4 intègre forcément des rapport pré-construits, c’est bien dans la possibilité d’en construire de nouveaux à la volée qu’il se démarque de son prédécesseur. Cette fonctionnalité d’exploration de la data, et ainsi de sa compréhension, laisse donc place à l’analyse et la découverte de nouveaux insights. Ainsi utilisez les tunnels personnalisables, de construction d’audience et le module d’exploration, puis rendez-les accessible dans data studio !

Si l’on tire le trait, l’accès à votre data se trouve donc fragmenté et multiplié : GA 4 se plaçant comme l’interface d’exploration et d’analyse “basique”, data studio comme l’outil de dashboarding et de partage, et Big Query comme moteur d’analyse avancée de celle-ci.

De l’exploration et toujours plus d’intégrations

Si GA 4 permet l’exploration et d’analyse à la volée, il est aussi un hub entre outils data et activation. Il intègre donc logiquement un linking avec Google Ads, Big Query, et davantage d’intégrations avec la suite Google sont attendues dans le futur, avec comme point d’orgue l’intégration Youtube promettant une vision sur les conversions provenant de la plateforme.

Ainsi qu’un rôle central pour les audiences

En repensant le système d’audiences, c’est une partie du lien avec ses autres outils que Google a repensée pour être toujours plus activation-centric.

En effet, pierre angulaire et lien direct avec Google Ads, le système de création d’audiences est désormais bien plus flexible : notion de fenêtre d’attribution, d’overlap entre audiences, attribution cross-platform et trigger lors de l’entrée dans une audience, tout est pensé pour une utilisation flexible et média-centric.

Et pour faire cela c’est le framework de collecte qui a été repensé

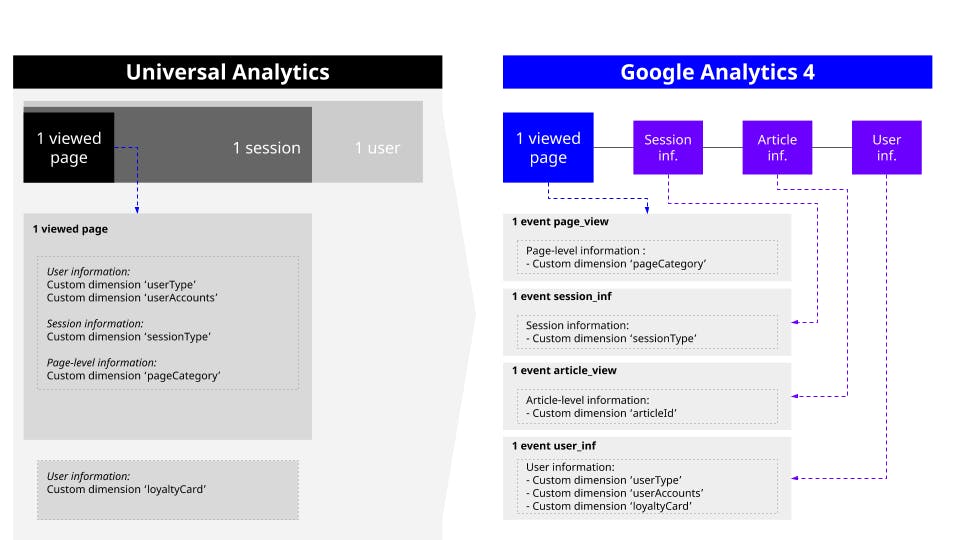

Le nouveau framework de collecte est basé en très grande partie sur celui de Firebase. En un mot : il est event-centric, et c’est un changement énorme. Mais qu’est ce que ça veut dire ?

Si l’on revient un peu en arrière, le framework de GA Universal était construit autour de la plateforme analytics, et non de l’usage. Conséquence : la donnée était collectée au chargement de la page, et on attendait une action utilisateur pour enrichir celle-ci.

Ces dernières années, l’augmentation des SPA (single page app), l’évolution des métriques de référence et l’asynchronicité croissante de la data rendent ce framework page >event illusoire. En effet la visualisation d’un contenu est par nature une suite logique d’événements à la temporalité différente : événement de chargement de la page, réponse de l’outil de recommandation de contenu, callback du CRM, calcul du score utilisateur, enrichissement du contexte de navigation, etc…

La collecte event-centric de GA4 répond donc à ce besoin de remontée multi contextuelle. Google plaçant la collecte data au centre d’un écosystème complet et hétérogène pouvant être résumé ainsi :

- Ma collecte de données ne sert pas qu’à des fins de visualisation directe dans un seul outil.

- Une bonne donnée est une donnée utilisée dans plusieurs aires de mon stack digital

- Les données perdent de la valeur dans le temps, bien qu’elles puissent en retrouver par regroupement et modeling, c’est dans l’instant présent qu’elles ont le plus de valeur

En conséquence :

- Il faut accepter une relative inutilité contextuelle de certaines données directement collectées au sein de mon outil analytics (url de thumbnail permettant la construction d’un outil de content recommandation par exemple).

- Mais les actions faites grâce à la data ont infiniment plus de valeur que la data elle même qui devient un facilitateur plus qu’un finalité.

- L’événement devient trigger universel, renforçant le lien avec les différents outils de la plateforme GCP.

Passer à un dataset “event-centric” n’est pas un fait mineur. On l’a vu, ce passage permet avant tout de changer de mindset à toutes les étapes du traitement de la donnée (collecte, analyse, activation), permettant aux marketeurs de passer d’une logique de “stockage et d’analyse” de la data à une logique de “réaction et de création” face à celle-ci.

Que faire à présent ?

Profitez du moment ! Prendre en main dès à présent GA 4 c’est se donner le temps nécessaire à la réflexion. “Ma collecte permet elle de constituer un datalake ?”, “Suit-elle les bonnes pratiques de nommage ?”, “Ma collecte est elle exhaustive ?”, “Me permet-elle d’activer des campagnes média et de personnalisation performantes ?”.

Toutes ces questions, ainsi qu’une phase d’onboarding des équipes, doivent être au centre d’un projet de migration. Et afin de ne pas tout bouleverser et de rendre le passage à GA 4 le plus fluide possible, il vaut mieux dès à présent mettre en place un dual tracking (collecter dans le même temps et avec la même structure les données au sein de GA Universal et GA 4) pour s’assurer de la continuité de l’accès aux données et explorer dès maintenant les nouvelles possibilités offertes par GA 4″ ?.

Si vous souhaitez en savoir plus sur GA 4 et son implémentation pour votre marque, je vous donne rendez-vous le mardi 17 novembre pour un webinar que j’animerai sur le sujet :